Secretos del algoritmo: se ha filtrado la documentación de ingeniería interna de la Búsqueda de Google. Pues ahora va a ser verdad que Google tiene un sistema para valorar la autoridad de los domininios. Sorpresa para los SEO.

Google, si estás leyendo esto, es demasiado tarde. 😉Es broma pero era algo que intuiamos los SEO de medios.

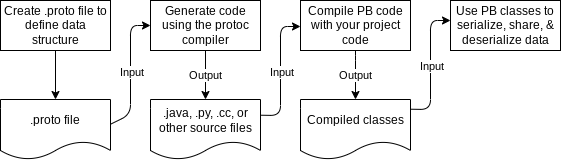

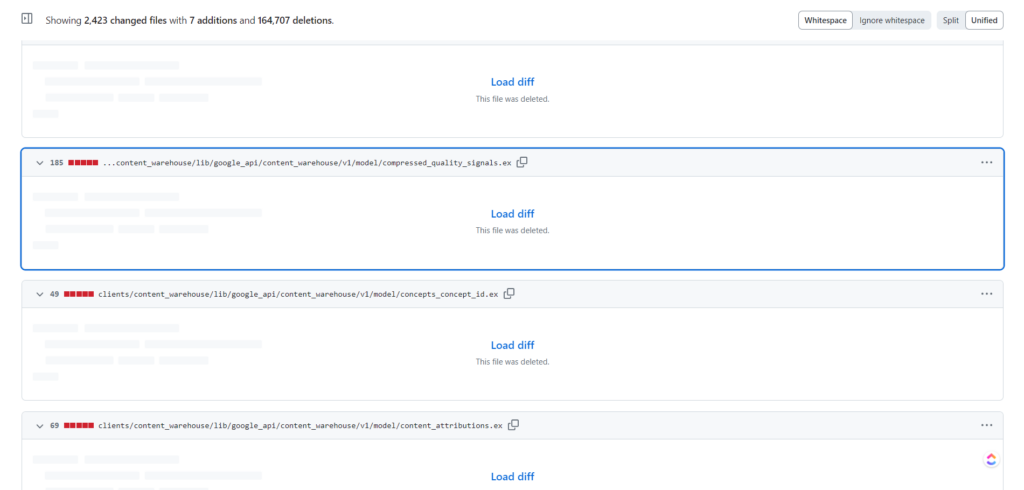

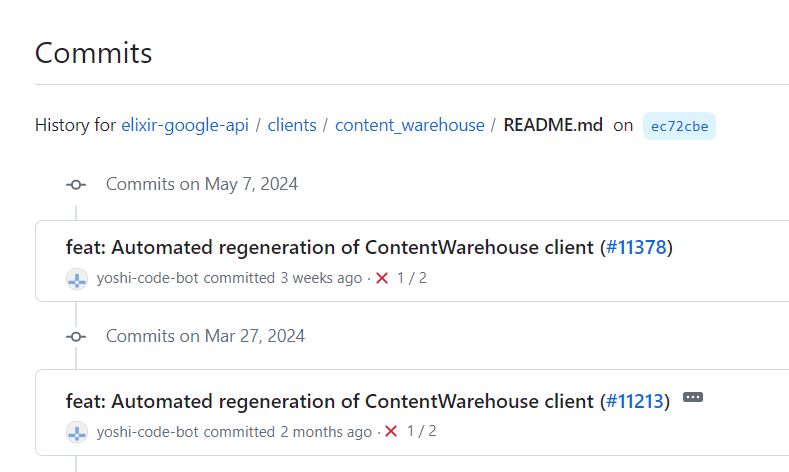

De acuerdo. Se crujen los nudillos . Vayamos directo al grano. Se filtró documentación interna para la API Content Warehouse de la Búsqueda de Google. Los microservicios internos de Google parecen reflejar lo que ofrece Google Cloud Platform y la versión interna de la documentación para el obsoleto Document AI Warehouse se publicó accidentalmente en un repositorio de código de la biblioteca del cliente. La documentación de este código también fue capturada por un servicio de documentación automatizado externo.

Según el historial de cambios, este error del repositorio de código se solucionó el 7 de mayo, pero la documentación automatizada aún está activa. En un esfuerzo por limitar la posible responsabilidad, no lo vincularé aquí, pero debido a que todo el código en ese repositorio se publicó bajo la licencia Apache 2.0 , a cualquiera que lo encontrara se le concedió un amplio conjunto de derechos, incluida la capacidad de usar , modificarlo y distribuirlo de todos modos.

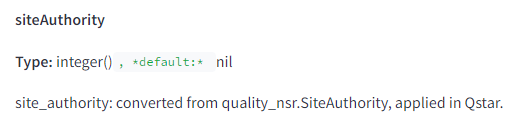

Revisé los documentos de referencia de API y los contextualicé con algunas otras filtraciones anteriores de Google y el testimonio antimonopolio del Departamento de Justicia. Estoy combinando eso con la extensa investigación de patentes y documentos técnicos realizada para mi próximo libro, The Science of SEO . Si bien no hay detalles sobre las funciones de puntuación de Google en la documentación que he revisado, existe una gran cantidad de información sobre los datos almacenados para contenido, enlaces e interacciones de los usuarios. También hay diversos grados de descripciones (que van desde decepcionantemente escasas hasta sorprendentemente reveladoras) de las características que se manipulan y almacenan.

Estaría tentado a llamarlos en términos generales “factores de clasificación”, pero eso sería impreciso. Muchos, incluso la mayoría, de ellos son factores de clasificación, pero muchos no lo son. Lo que haré aquí es contextualizar algunos de los sistemas y características de clasificación más interesantes (al menos, los que pude encontrar en las primeras horas de revisión de esta filtración masiva) en base a mi extensa investigación y las cosas que Google me ha dicho. nos mintió a lo largo de los años.

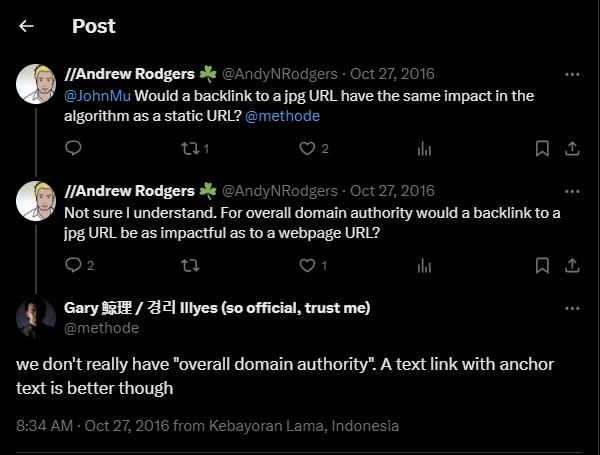

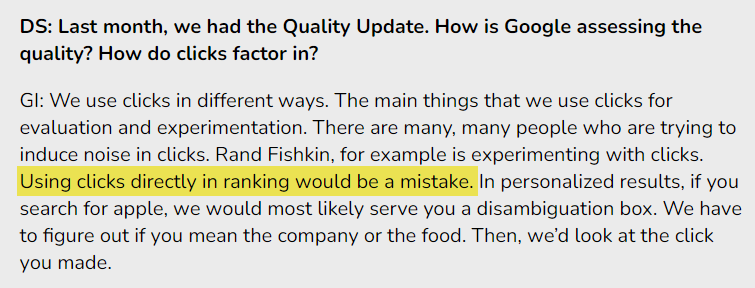

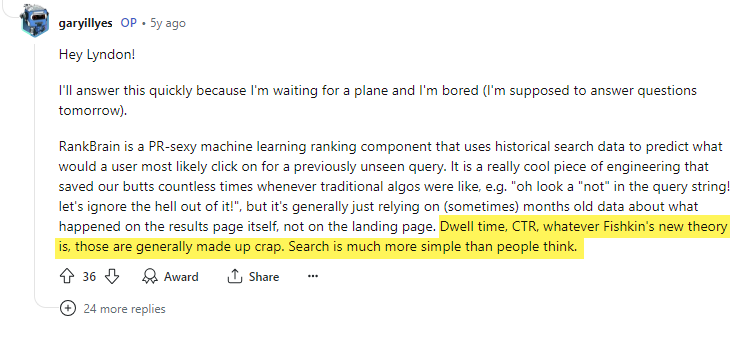

«Mentir» es duro, pero es la única palabra precisa que se puede utilizar aquí. Si bien no necesariamente culpo a los representantes públicos de Google por proteger su información patentada, sí discrepo de sus esfuerzos por desacreditar activamente a personas en los mundos del marketing, la tecnología y el periodismo que han presentado descubrimientos reproducibles. Mi consejo para los futuros empleados de Google que hablen sobre estos temas: a veces es mejor decir simplemente «no podemos hablar de eso». Su credibilidad importa, y cuando salen a la luz filtraciones como ésta y testimonios como el del juicio del Departamento de Justicia, resulta imposible confiar en sus declaraciones futuras.

LAS ADVERTENCIAS

Creo que todos sabemos que la gente trabajará para desacreditar mis hallazgos y análisis de esta filtración. Algunos se preguntarán por qué es importante y dirán «pero eso ya lo sabíamos». Entonces, dejemos de lado las advertencias antes de pasar a lo bueno.

- Tiempo y contexto limitados: con el fin de semana festivo, solo he podido pasar unas 12 horas aproximadamente en profunda concentración en todo esto. Estoy increíblemente agradecido con algunas partes anónimas que fueron de gran ayuda al compartir sus ideas conmigo para ayudarme a ponerme al día rápidamente. Además, al igual que la filtración de Yandex que cubrí el año pasado , no tengo una imagen completa. Donde teníamos código fuente para analizar y ninguna de las ideas detrás de Yandex, en este caso tenemos algunas de las ideas detrás de miles de características y módulos, pero ningún código fuente. Tendrán que perdonarme por compartir esto de una manera menos estructurada de lo que lo haré unas semanas después de haberme sentado más tiempo con el material.

- Sin funciones de puntuación: no sabemos cómo se ponderan las características en las distintas funciones de puntuación posteriores. No sabemos si se está utilizando todo lo disponible. Sabemos que algunas funciones están obsoletas. A menos que se indique explícitamente, no sabemos cómo se utilizan las cosas. No sabemos dónde sucede todo en el proceso. Tenemos una serie de sistemas de clasificación con nombres que se alinean vagamente con la forma en que Google los ha explicado, cómo los SEO han observado las clasificaciones en la naturaleza y cómo las solicitudes de patentes y la literatura de relaciones internacionales lo explican. En última instancia, gracias a esta filtración, ahora tenemos una imagen más clara de lo que se está considerando y que puede informar en qué nos centramos y en qué ignoramos en el SEO en el futuro.

- Probablemente la primera de varias publicaciones: esta publicación será mi intento inicial de lo que he revisado. Es posible que publique publicaciones posteriores a medida que continúo profundizando en los detalles. Sospecho que este artículo hará que la comunidad de SEO se apresure a analizar estos documentos y, colectivamente, descubriremos y recontextualizaremos cosas en los próximos meses.

- Esto parece ser información actual: lo mejor que puedo decir es que esta filtración representa la arquitectura activa actual del almacenamiento de contenido de búsqueda de Google a partir de marzo de 2024. (Indique a una persona de relaciones públicas de Google que dice que estoy equivocado. En realidad, saltémonos la canción). y bailar, todos ustedes). Según el historial de confirmaciones, el código relacionado se introdujo el 27 de marzo de 2024 y no se eliminó hasta el 7 de mayo de 2024.

- Correlación no es causalidad . Bueno, esto realmente no se aplica aquí, pero solo quería asegurarme de cubrir todas las bases.

HAY FUNCIONES DE CLASIFICACIÓN DE 14K Y MÁS EN LOS DOCUMENTOS

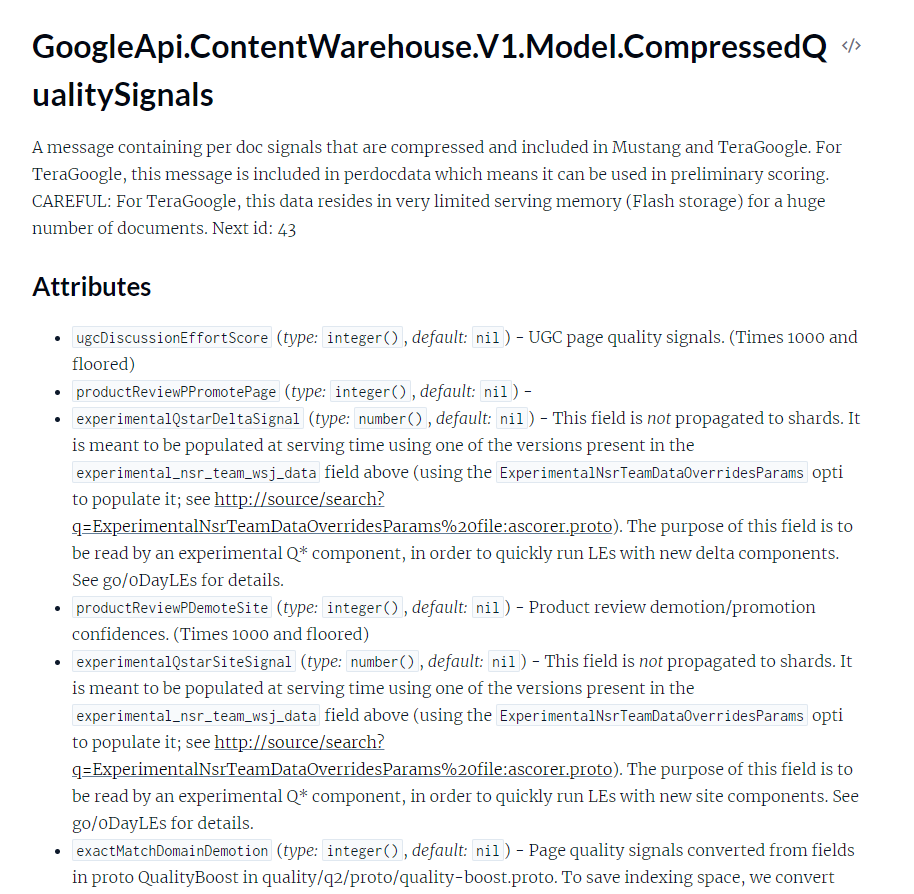

Hay 2596 módulos representados en la documentación de la API con 14.014 atributos (características) que se ven así:

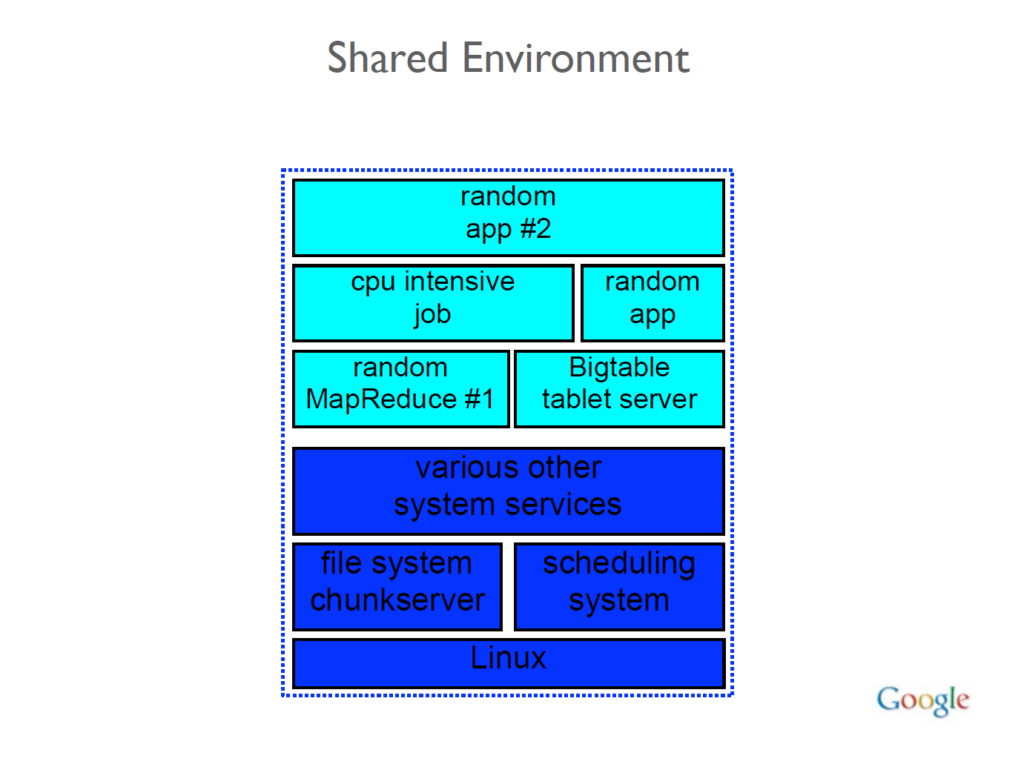

Los módulos están relacionados con componentes de YouTube, Asistente, Libros, búsqueda de videos, enlaces, documentos web, infraestructura de rastreo, un sistema de calendario interno y People API. Al igual que Yandex, los sistemas de Google operan en un repositorio monolítico (o “monorepo”) y las máquinas operan en un entorno compartido. Esto significa que todo el código se almacena en un solo lugar y cualquier máquina de la red puede formar parte de cualquiera de los sistemas de Google.

Fuente https://ipullrank.com/google-algo-leak

. Leer artículo completo en Frikipandi Secretos del algoritmo: se ha filtrado la documentación de ingeniería interna de la Búsqueda de Google. Frikipandi – Web de Tecnología – Lo más Friki de la red. Web de Tecnología con las noticias más frikis de Internet. Noticias de gadgets, Hardware, Software, móviles e Internet. Frikipandi

Frikipandi – Web de Tecnología – Lo más Friki de la red. Web de Tecnología con las noticias más frikis de Internet. Noticias de gadgets, Hardware, Software, móviles e Internet. Frikipandi